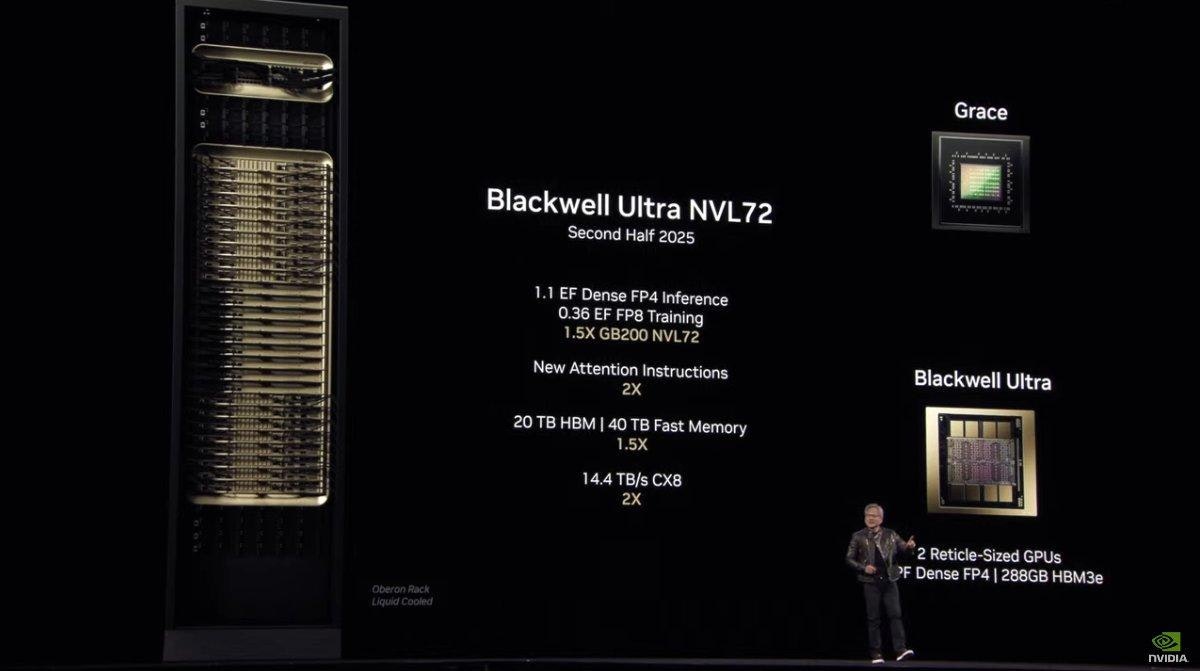

NVIDIA于年度活动GTC 2025的重点之一即是聚焦在Blackwell升级版本的Blackwell Ultra GPU,Blackwell Ultra基于GTC 2024公布的Blackwell晶片,并进一步进行增强与搭配更大容量的记忆体,基于Blackwell Ultra的GPU率先搭载高达288GB的HBM3e记忆体,并辅以增强FP4性能,可实现1.5倍的FP4推论性能,对比基于Hopper架构建构的AI工厂有望创造50倍的营收机会;同时NVIDIA也同步宣布针对AI基础架构的NVIDIA Spectrum-X Enhanced 800G乙太网路系统,还有增强设计的NVIDIA GB300 NVL72与NVDIA B300 NVL16,以及基于GB300 NVL72构成的Blackwell Ultra DGX SuperPOD系统。

NVIDIA的合作伙伴预计自2025年下半年推出搭载Blackwell Ultra的产品,除了Aivres、华擎科技、华硕、鸿海科技集团、技嘉科技、英业达、和硕联合科技、云达科技、纬创与纬颖,思科、戴尔科技集团、慧与科技、联想集团与美超微也皆会推出搭载各种型态、搭载Blackwell Ultra的伺服器;另外Amazon Web Services(AWS)、Google Cloud、Microsoft Azure 与 Oracle Cloud Infrastructure,以及GPU云端供应商 CoreWeave、Crusoe、Lambda、Nebius、Nscale、Yotta与YTL等将率先提供Blackwell Ultra驅动的执行个体。

NVIDIA强调Blackwell Ultra于FP4性能进行增强,辅以频宽更高、容量更大的HBM3e记忆体可执行更大参数模型与更好的整体性能,相较Hopper架构则受惠吞吐量、运算性能双双提升,能够成就50倍的获利机会。基于Blackwell Ultra的GB300 SuperChip则同样以一个Grace CPU晶片搭配2个Blackwell Ultra GPU晶片,配有288GB的HBM3e记忆体480GB的LPDDR5x记忆体。NVIDIA强调Blackwell Ultra适合如代理型AI、实体AI等需要进行精密複杂推论、迭代规划与产生即时逼真影像或大规模训练机器人及自驾车的情境。

同时Blackwell Ultra平台也导入NVIDIA Spectrum-X Ethernet以及NVIDIA Quantum-X800 InfiniBand网路平台,透过NVIDIA ConnectX-8 SuperNIC,为系统的每个GPU提供800 Gb/s的资料传输性能,使跨机架的远端记忆体存取更快、延迟更低,借此降低AI工厂与云端资料中心执行AI推论的连接瓶颈问题;同时因应多租户网路、GPU弹性运算、加速资料存取与安全性,Blackwell Ultra平台也结合具资料卸载功能的NVIDIA BlueField-3 DPU。

▲基于GB300 NVL72的DGX SuperPod with DGX GB300具备576个Blackwell Ultra GPU,可实现11.5 ExaFLOPS的FP4算力

此外基于Blackwell Ultra架构的GB300超级晶片的GB300 NVL72机架系统进行增强设计,基于36个Grace CPU晶片与72个Blackwell Ultra GPU晶片,能够提升能源效率与服务稳定性,达到20TB的HBM记忆体与40TB高速记忆体(基于LPDDR5x),机内的NVLink频宽则高达130TB/s,并具备14.4TB/s的网路频宽,单一机架可实现1.1 ExaFLOPS的FP4推论性能,以执行DeepSeek-R1 671B模型的推论为例,使用Hopper架构的H100约具备100 Tok/s性能与1.5分钟的执行时间,而GB300 NVL72则可实现1,000 Tok/s的性能与仅10秒的执行时间,大幅提升Token的产生量与缩减推论时间。

NVIDIA也同步推出基于16个Blavkwell Ultra GPU的NVDIA HGX B300 NVL16,相较Hopper世代于大型语言模型推论增加11倍,运算性能提升7倍,记忆体容量则提高4倍,因应当前大型语言模型等生成式AI推论需求。

因应GB300 NVL72规划的DGX SuperPod with DGX GB300系统共具备288个Grace CPU与576个Blackwell Ultra GPU,等同由8套GB300 NVL72串接而成,可提供高达11.5 ExaFLOPS FP4的AI算力,并采用全新设计的NVIDIA MGX机架设计,并采用可靠的风冷系统。

发表评论 取消回复